近年来,大型语言模型(LLM)在自然语言处理领域取得了显著进展。DeepSeek 作为一款高性能的大模型,受到了广泛关注。本文将详细介绍如何通过 Ollama 在本地部署 DeepSeek 的各类大模型,并说明不同参数模型对硬件的要求。

1. DeepSeek 大模型简介

DeepSeek 是一款基于 Transformer 架构的大规模语言模型,支持多种参数规模(如 7B、13B、30B 等)。不同参数规模的模型在性能和硬件需求上有所不同:

- 7B 模型:适合普通开发者,对硬件要求较低。

- 13B 模型:适合中等规模的任务,需要较强的硬件支持。

- 30B 模型:适合高性能计算场景,需要高端硬件。

2. 什么是 Ollama?

Ollama 是一个开源的本地大模型部署工具,支持多种大模型的加载和运行。它提供了简单易用的命令行接口,适合开发者和研究人员在本地环境中快速部署和测试大模型。

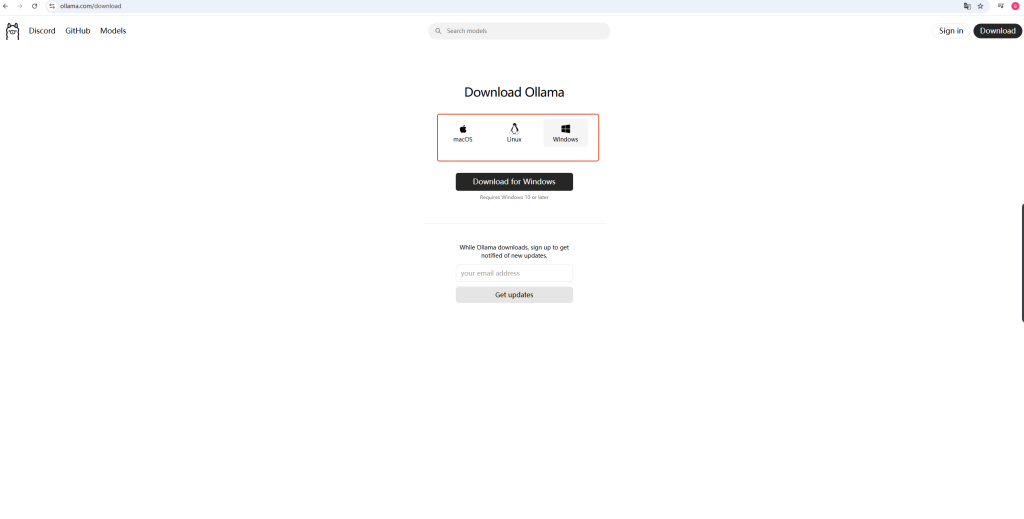

Ollama官网下载链接:https://ollama.com/download

3. 硬件要求

在本地部署 DeepSeek 大模型之前,请确保您的硬件满足以下最低要求:

| 模型参数 | 显存要求 | 内存要求 | 推荐 GPU |

|---|---|---|---|

| 7B | 8 GB | 16 GB | NVIDIA RTX 3060 或更高 |

| 14B | 16 GB | 32 GB | NVIDIA RTX 3090 或更高 |

| 32B | 24 GB | 64 GB | NVIDIA A100 或更高 |

注意事项:

- 显存:显存是运行大模型的关键,显存不足会导致模型无法加载或运行缓慢。

- 内存:内存用于存储模型权重和中间计算结果,建议至少为显存的 2 倍。

- 存储:模型文件较大(7B 约 15 GB,13B 约 30 GB,30B 约 60 GB),请确保有足够的磁盘空间。

4. 部署步骤

4.1 安装 Ollama

- 在官网下载ollama:Ollama官网下载链接:https://ollama.com/download

- 确保已安装 Python 3.8 或更高版本。

- 安装 CUDA 和 cuDNN(如果使用 GPU)。

- 安装 Ollama:选择相应的版本,下载,然后安装即可。

- 验证安装:

4.2 下载 DeepSeek 模型

- 获取模型文件:

- 访问 DeepSeek 的官方 GitHub 仓库或 Hugging Face 模型库,下载所需的模型文件(如

deepseek-7b、deepseek-13b等)。 - 模型文件通常为

.bin或.pt格式。

- 访问 DeepSeek 的官方 GitHub 仓库或 Hugging Face 模型库,下载所需的模型文件(如

- 放置模型文件:

将下载的模型文件放置在本地目录中,例如:~/models/deepseek-7b/

4.3 通过ollama拉取模型(4.2的步骤即可省略)

# 运行 1.5B Qwen DeepSeek R1

ollama run deepseek-r1:1.5b

# 运行 7B Qwen DeepSeek R1

ollama run deepseek-r1:7b

# 运行 8B Llama DeepSeek R1

ollama run deepseek-r1:8b

# 运行 14B Qwen DeepSeek R1

ollama run deepseek-r1:14b

# 运行 32B Qwen DeepSeek R1

ollama run deepseek-r1:32b

# 运行 70B Llama DeepSeek R1

ollama run deepseek-r1:70b

提示:请确保您已安装 Ollama,并且下载了相应的 DeepSeek R1 模型。

4.4 配置 Ollama

- 创建配置文件:

在模型目录下创建一个config.yaml文件,内容如下:model: name: deepseek-7b path: ~/models/deepseek-7b/model.bin device: cuda # 使用 GPU,若仅使用 CPU 则改为 "cpu" - 启动 Ollama:

运行以下命令启动 Ollama 并加载模型:ollama serve --config ~/models/deepseek-7b/config.yaml

4.5 测试模型

- 运行推理:

使用 Ollama 提供的命令行工具进行推理测试:ollama run "你好,DeepSeek!" - 检查性能:

- 观察推理速度和资源占用情况。

- 如果性能不足,可以尝试降低模型精度(如使用 FP16)或升级硬件。

5 更多模型下载

DeepSeek-R1 模型

| 模型 | #总参数 | #已激活参数 | 上下文长度 | 下载 (HuggingFace) |

|---|---|---|---|---|

| DeepSeek-R1-Zero | 671B | 37B | 128千 | 🤗 HuggingFace |

| DeepSeek-R1 | 671B | 37B | 128千 | 🤗 HuggingFace |

DeepSeek-R1-Zero 和 DeepSeek-R1 基于 DeepSeek-V3-Base 进行训练。有关模型架构的更多详细信息,请参阅DeepSeek-V3存储库。

DeepSeek-R1-Distill 模型

| 模型 | 基础模型 | 下载 (HuggingFace) |

|---|---|---|

| DeepSeek-R1-Distill-Qwen-1.5B | Qwen2.5-Math-1.5B | 🤗 HuggingFace |

| DeepSeek-R1-Distill-Qwen-7B | Qwen2.5-Math-7B | 🤗 HuggingFace |

| DeepSeek-R1-Distill-Llama-8B | Llama-3.1-8B | 🤗 HuggingFace |

| DeepSeek-R1-Distill-Qwen-14B | Qwen2.5-14B | 🤗 HuggingFace |

| DeepSeek-R1-Distill-Qwen-32B | Qwen2.5-32B | 🤗 HuggingFace |

| DeepSeek-R1-Distill-Llama-70B | Llama-3.3-70B-Instruct | 🤗 HuggingFace |

DeepSeek-R1-Distill 模型基于开源模型进行了微调,使用了 DeepSeek-R1 生成的样本。官方对其配置和分词器进行了轻微更改。请使用我们的设置来运行这些模型。

6 评估结果

模型对比评估

| 类别 | 基准(公制) | 克劳德-3.5-十四行诗-1022 | GPT-4o 0513 | DeepSeek V3 | OpenAI o1-mini | OpenAI o1-1217 | DeepSeek R1 |

|---|---|---|---|---|---|---|---|

| 建筑学 | – | – | 教育部 | – | 教育部 | – | 教育部 |

| # 激活参数 | – | – | 37B | – | 37B | – | 37B |

| # 总参数 | – | – | 671B | – | 671B | – | 671B |

| 英语 | MMLU(通过@1) | 88.3 | 87.2 | 88.5 | 85.2 | 91.8 | 90.8 |

| MMLU-Redux(EM) | 88.9 | 88.0 | 89.1 | 86.7 | – | 92.9 | |

| MMLU-Pro(EM) | 78.0 | 72.6 | 75.9 | 80.3 | – | 84.0 | |

| 掉落 (3 发 F1) | 88.3 | 83.7 | 91.6 | 83.9 | 90.2 | 92.2 | |

| IF-Eval(提示严格) | 86.5 | 84.3 | 86.1 | 84.8 | – | 83.3 | |

| GPQA-钻石级 (Pass@1) | 65.0 | 49.9 | 59.1 | 60.0 | 75.7 | 71.5 | |

| SimpleQA(正确) | 28.4 | 38.2 | 24.9 | 7.0 | 47.0 | 30.1 | |

| 框架(配件) | 72.5 | 80.5 | 73.3 | 76.9 | – | 82.5 | |

| AlpacaEval2.0 (LC-胜率) | 52.0 | 51.1 | 70.0 | 57.8 | – | 87.6 | |

| OpenAI | ArenaHard(GPT-4-1106) | 85.2 | 80.4 | 85.5 | 92.0 | – | 92.3 |

| 代码 | LiveCodeBench (Pass@1-COT) | 33.8 | 34.2 | – | 53.8 | 63.4 | 65.9 |

| Codeforces(百分位数) | 20.3 | 23.6 | 58.7 | 93.4 | 96.6 | 96.3 | |

| Codeforces(评级) | 717 | 759 | 1134 | 1820 | 2061 | 2029 | |

| SWE 已验证(已解决) | 50.8 | 38.8 | 42.0 | 41.6 | 48.9 | 49.2 | |

| Aider-Polyglot (Acc.) | 45.3 | 16.0 | 49.6 | 32.9 | 61.7 | 53.3 | |

| 数学 | AIME 2024(通行证@1) | 16.0 | 9.3 | 39.2 | 63.6 | 79.2 | 79.8 |

| 数学-500 (通过@1) | 78.3 | 74.6 | 90.2 | 90.0 | 96.4 | 97.3 | |

| CNMO 2024 (通行证@1) | 13.1 | 10.8 | 43.2 | 67.6 | – | 78.8 | |

| 中文 | CLUEWSC(EM) | 85.4 | 87.9 | 90.9 | 89.9 | – | 92.8 |

| C-评估(EM) | 76.7 | 76.0 | 86.5 | 68.9 | – | 91.8 | |

| C-SimpleQA(正确) | 55.4 | 58.7 | 68.0 | 40.3 | – | 63.7 |

蒸馏模型评估

| 模型 | AIME 2024 通行证@1 | AIME 2024 缺点@64 | MATH-500 通过@1 | GPQA 钻石通行证@1 | LiveCodeBench 通行证@1 | CodeForces 评级 |

|---|---|---|---|---|---|---|

| GPT-4o-0513 | 9.3 | 13.4 | 74.6 | 49.9 | 32.9 | 759 |

| 克劳德-3.5-十四行诗-1022 | 16.0 | 26.7 | 78.3 | 65.0 | 38.9 | 717 |

| o1-迷你 | 63.6 | 80.0 | 90.0 | 60.0 | 53.8 | 1820 |

| QwQ-32B-预览 | 44.0 | 60.0 | 90.6 | 54.5 | 41.9 | 1316 |

| DeepSeek-R1-Distill-Qwen-1.5B | 28.9 | 52.7 | 83.9 | 33.8 | 16.9 | 954 |

| DeepSeek-R1-Distill-Qwen-7B | 55.5 | 83.3 | 92.8 | 49.1 | 37.6 | 1189 |

| DeepSeek-R1-Distill-Qwen-14B | 69.7 | 80.0 | 93.9 | 59.1 | 53.1 | 1481 |

| DeepSeek-R1-Distill-Qwen-32B | 72.6 | 83.3 | 94.3 | 62.1 | 57.2 | 1691 |

| DeepSeek-R1-Distill-Llama-8B | 50.4 | 80.0 | 89.1 | 49.0 | 39.6 | 1205 |

| DeepSeek-R1-Distill-Llama-70B | 70.0 | 86.7 | 94.5 | 65.2 | 57.5 | 1633 |

评论列表 (0条):

加载更多评论 Loading...